Автономні системи керування вже не виглядять як футуристичний витвір: вони вбудовані в тисячі машин і формують очікування користувачів щодо безпеки та зручності. У цьому контексті особливу увагу привертає система Full Self‑Driving (FSD), що покладається на потужні нейромережі й амбітні технічні рішення. Виникає питання: наскільки ці алгоритми стійкі до реального світу — до сонця, пилу й несподіваних контрастів, які підстерігають на дорозі?

У ролику показано салон Tesla під час сонячного дня: автопілот працює, згодом система раптово відключається, і водій бере керування на себе. Немає кричущих порушень правил у кадрі, але ситуація турбує: довіра до автопілота хитка, коли фактори природи втручаються в роботу камер.

У випадку згаданої машини встановлена Hardware 3 — апаратна платформа, яка з 2019 року обробляє нейромережеві обчислення для FSD і вже вважається менш сучасною порівняно з новішими модифікаціями Tesla.

Повернення до архітектури: з 2021 року Tesla свідомо відмовилась від радара та ультразвуку, обравши винятково камерну систему — Tesla Vision. Це означає, що FSD працює виключно з відеопотоків, без апаратного резервування. Такий підхід дає переваги в уніфікації даних, проте під час складного освітлення втрачається можливість підтвердження інформації з іншого сенсора.

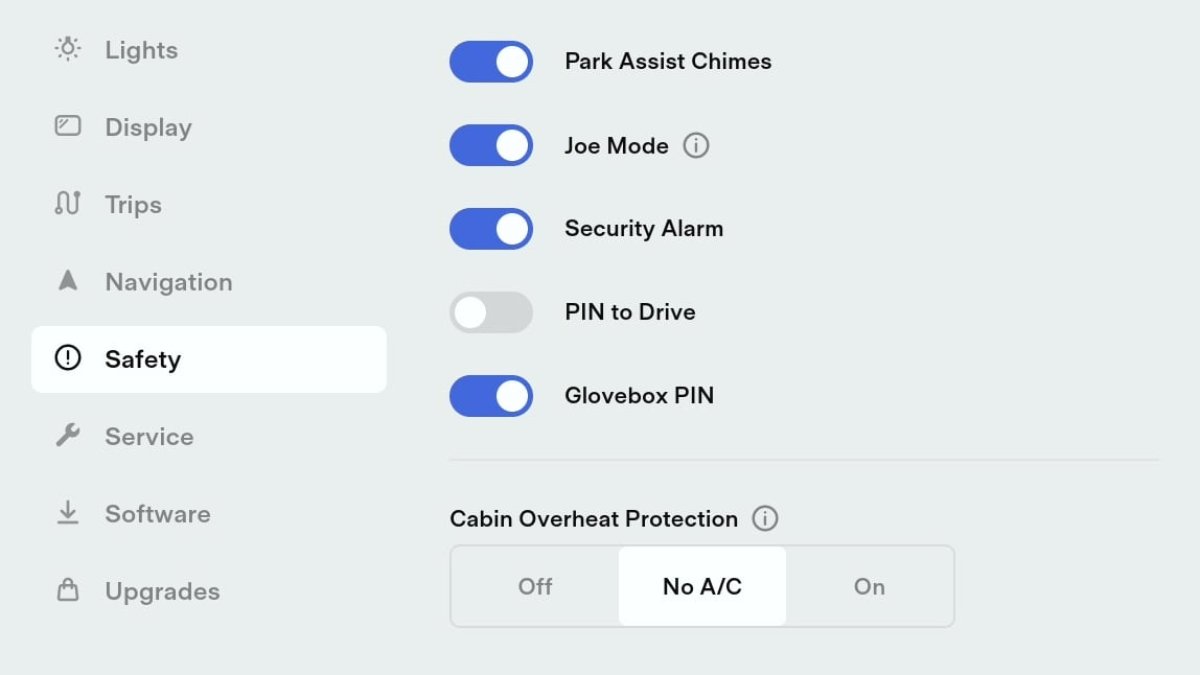

Офіційні вказівки в посібнику власника прямо попереджають: яскраве світло, зокрема прямі сонячні промені, можуть послабити здатність камер розпізнавати розмітку й об’єкти. Незважаючи на прогрес у алгоритмах, системи Tesla досі формально належать до SAE рівня 2 — постійний контроль з боку людини залишається обов’язковим.

Навчальні відео й репортажі на YouTube ілюструють типову ситуацію: сонячні проблиски на камерах у стійці B призводять до повідомлення «перевірте камеру» навіть за чистих лінз. Причина — кадри з переекспозицією або надвисокою контрастністю ставлять нейромережі в складні умови, яких не було достатньо в тренувальних вибірках.

У жовтні NHTSA розпочала попередню оцінку роботи FSD приблизно в 2,40 млн автомобілів, зосередивши увагу на інцидентах, де фактори на кшталт відблисків, туману або піднятого пилу сприяли некоректній роботі системи. Серед розглянутих випадків — трагічний наїзд на пішохода в листопаді 2023 року біля Римрока, Арізона; сонячне світло згадується як один із сприяючих факторів.

Технічне підґрунтя проблеми зрозуміле: фронтальні камери під прямим сонцем часто «втрачають» деталі кадру — дорожні знаки, лінії розмітки, силуети пішоходів і велосипедистів розчиняються в яскравому світлі. Особливо вразливі автомобілі з Hardware 3, де обчислювальні можливості й чутливість камер менш досконалі, ніж у пізніших модифікаціях.

Глибинний аналіз вказує на кілька причин таких збоїв. По-перше, нейронні мережі потрапляють у зону «невідомого» при зіткненні з кадрами, що мають екстремальний динамічний діапазон; якщо такі приклади були недостатньо представлені під час навчання, модель починає помилятися. По-друге, банальні фактори — забруднені або запітнілі лінзи, відблиски на лобовому склі, ранкова роса — значно посилюють проблему й можуть примусити систему або неправильно інтерпретувати сцену, або з обережності вимкнути автопілот. По-третє, відсутність апаратного резерву — радару чи lidar — позбавляє можливості «перевірити» сумнівні візуальні дані.

Що це означає для ринку та користувачів? По-перше, технологія показує реальну межу поточного підходу: камерна архітектура дає високу роздільну здатність і багаті дані в більшості сценаріїв, але вразлива до оптичних артефактів. По-друге, розв’язання проблеми лежить на кількох площинах: поліпшення тренувальних датасетів, апаратні оновлення камер і чутливості, а також гібридні системи сенсорів для підвищення надійності.

Перспективи виглядають так: інвестиції в моделі, стійкі до контрасту, та вдосконалення обробки зображень здатні зменшити частоту помилкових відключень. Але до повноцінної автономії без контролю людини ще далеко — потрібні як технічні рішення, так і регуляторні підтвердження надійності. Паралельно варто очікувати, що виробники почнуть більше інвестувати в sensor fusion або альтернативні джерела даних там, де камера виявляється слабкою ланкою.

rel

У підсумку: система Full Self‑Driving на базі Tesla Vision демонструє значний прогрес, але пряме сонячне світло залишається серйозним викликом, особливо для машин із Hardware 3. Це нагадування про те, що розвиток автономності — не пряма лінія вперед, а серія маневрів навколо природних обмежень. Чи означає це, що треба відмовитися від камерних рішень? Ні — але треба бути реалістичним у очікуваннях, інвестувати в резервні сенсори та доопрацьовувати алгоритми. Ринок і користувачі отримають вигоду від підходу, який поєднує алгоритмічну майстерність із апаратною стійкістю, адже навіть найкращий алгоритм не врятує автомобіль, якщо його «очі» засліплені сонцем.